-

Azzurri, allenamento a Coverciano poi partenza per Ungheria

Azzurri, allenamento a Coverciano poi partenza per Ungheria

-

Ligabue a Caserta dopo Campovolo 'nel 2026 all'Olimpico'

-

Gazprom, 'Europa a rischio gas se l'inverno sarà freddo'

Gazprom, 'Europa a rischio gas se l'inverno sarà freddo'

-

US Open: stasera Santanchè alla finale in rappresentanza Governo

-

Vincitori di Musicultura in concerto nel carcere di Barcaglione

Vincitori di Musicultura in concerto nel carcere di Barcaglione

-

Urso, anche con dazi potrebbero aprirsi nuove prospettive

-

Media, 'Kiev rivendica nuovo attacco all'oleodotto Druzhba'

Media, 'Kiev rivendica nuovo attacco all'oleodotto Druzhba'

-

Calcio:PSG chiede 'coordinamento medico-sportivo club-Bleus'

-

Fabrizio Bosso, 'è giusto che gli artisti intervengano su Gaza'

Fabrizio Bosso, 'è giusto che gli artisti intervengano su Gaza'

-

Il paese d'origine si prepara ai funerali di Armani

-

Qualificazioni Mondiali: sloveno Vincic arbitra Israele-Italia

Qualificazioni Mondiali: sloveno Vincic arbitra Israele-Italia

-

A Rimini una nuova targa per ricordare Lucio Battisti

-

Sal Da Vinci, "Rossetto e caffè" conquista Piazza Plebiscito

Sal Da Vinci, "Rossetto e caffè" conquista Piazza Plebiscito

-

Secondo giorno di camera ardente per Armani, fila dalle 7

-

Pallavolo: bis Italia, 3-1 al Giappone in 2/o test pre-mondiale

Pallavolo: bis Italia, 3-1 al Giappone in 2/o test pre-mondiale

-

Cnn, Trump verso incontro con Xi il mese prossimo

-

Sabalenka bis agli Us Open, battuta in finale Anisimova

Sabalenka bis agli Us Open, battuta in finale Anisimova

-

Eurobasket: la Serbia favorita eliminata, Finlandia ai quarti

-

Tamberi ha deciso 'vado ai mondiali, ci vediamo a Tokyo'

Tamberi ha deciso 'vado ai mondiali, ci vediamo a Tokyo'

-

Jarmusch, l'arte affronti il mondo con l'empatia

-

E' morto Alfredo Ambrosetti, il fondatore del Forum di Cernobbio

E' morto Alfredo Ambrosetti, il fondatore del Forum di Cernobbio

-

Leone d'oro a Father Mother Sister Brother di Jim Jarmusch

-

Premio per la migliore sceneggiatura a Donzelli e Marchand

Premio per la migliore sceneggiatura a Donzelli e Marchand

-

Il Premio Speciale della Giuria a Sotto le nuvole di Rosi

-

Coppa Volpi maschile a Toni Servillo per La Grazia

Coppa Volpi maschile a Toni Servillo per La Grazia

-

Il Leone del futuro va a Short Summer

-

Porcaroli, 'dedico premio Orizzonti agli amici della Flotilla'

Porcaroli, 'dedico premio Orizzonti agli amici della Flotilla'

-

Duemila fan al raduno del club di Laura Pausini a Faenza

-

Vuelta: Soler vince la 14ma tappa, Vingegaard resta leader

Vuelta: Soler vince la 14ma tappa, Vingegaard resta leader

-

MotoGP: Claudio Domenicali, nulla é fuori portata per Ducati

-

++ Save the Children, 'oltre 20mila bambini uccisi a Gaza' ++

++ Save the Children, 'oltre 20mila bambini uccisi a Gaza' ++

-

'Trump punta al controllo del memoriale dell'11 settembre'

-

Zakharova, 'i leader Ue come i sette nani di Trump, ma mutanti'

Zakharova, 'i leader Ue come i sette nani di Trump, ma mutanti'

-

Mondiali volley: Fahr, 'è stata una grande vittoria di squadra'

-

Eurobasket: Pozzecco "Doncic non si ferma ma ci proveremo"

Eurobasket: Pozzecco "Doncic non si ferma ma ci proveremo"

-

Verstappen: "Pole fantastica, provo a fare magie"

-

A Monza Verstappen partirà dalla pole

A Monza Verstappen partirà dalla pole

-

Mondiali: 3-2 al Brasile, le azzurre in finale

-

A La Grazia di Sorrentino il premio Pasinetti

A La Grazia di Sorrentino il premio Pasinetti

-

Italia 3/a in Ue per 'idroelettrico, crescita potenziale del 10%

-

Masoero (Siemens Italia),'da AI fino a 100 miliardi Pil imprese'

Masoero (Siemens Italia),'da AI fino a 100 miliardi Pil imprese'

-

La Filarmonica del Comunale di Modena in tournée in Giappone

-

Marc Marquez, "felice del titolo costruttori per Ducati"

Marc Marquez, "felice del titolo costruttori per Ducati"

-

MotoGP: Marc Marquez vince la Sprint in Catalunya

-

Esperto,con accordo Mercosur bene meccanica, rischi agricoltura

Esperto,con accordo Mercosur bene meccanica, rischi agricoltura

-

Exarchopoulos, 'l'IA? Più inquietante la stupidità umana'

-

I ciclisti di Udine con i campanelli suoneranno una sinfonia

I ciclisti di Udine con i campanelli suoneranno una sinfonia

-

Wafa, almeno 13 morti negli attacchi aerei a Gaza City

-

Usa, il Powerball raggiunge un jackpot da 1,8 miliardi

Usa, il Powerball raggiunge un jackpot da 1,8 miliardi

-

Mondiale volley: Giappone battuto, Turchia la prima finalista

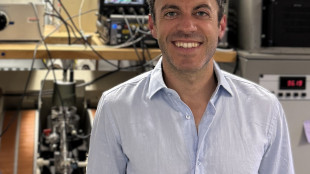

Il paradosso dei chatbot, più crescono più sbagliano

Dà risposte errate piuttosto che ammettere l'ignoranza

Più crescono e fanno esperienza, maggiore è il rischio che rispondano in modo errato piuttosto che ammettere di non saper rispondere: è uno dei grandi problemi dei grandi modelli linguistici che alimentano i chatbot, come ChatGpt e Llama. A dirlo è lo studio pubblicato sulla rivista Nature da José Hernández-Orallo, dell'Istituto di ricerca per l'Intelligenza Artificiale di Valencia in Spagna, che sottolinea inoltre come questi errori sfuggano facilmente agli umani. Una delle importanti caratteristiche dei grandi modelli linguistici, o Llm, è la capacità di evolvere nel tempo integrando al loro interno nuove informazioni derivanti dalle interazioni con gli utenti o con gli sviluppatori, così da diventare teoricamente sempre più affidabili. Ma analizzando questo percorso in tre degli Llm più polari, in particolare ChatGpt di OpenAi, Llama di Meta e il modello aperto Bloom, i ricercatori spagnoli hanno osservato un cambiamento del loro comportamento. Secondo gli autori della ricerca i tre modelli inizialmente erano più propensi di oggi nell'ammettere di non poter rispondere a domande su questioni su cui non si sentivano certi di dare risposte accurate. Una prudenza che è andata gradualmente svanendo: "i modelli 'ingranditi' e modellati tendono a dare una risposta apparentemente sensata, ma sbagliata, molto più spesso rispetto al passato", affermano i ricercatori nell'articolo. I chatbot "stanno diventando più bravi a fingere di essere informati", ha commentato Hernández-Orallo. Un problema che si aggiunge inoltre all'incapacità da parte degli umani di riuscire a notare questi errori, spesso perché ci si fida automaticamente della macchina. Un problema che potrebbe essere parzialmente risolto impostando negli Llm una sorta di soglia di affidabilità più alta, al di sotto della quale l'IA non rilascia una risposta. Scelta possibile per i chatbot ideati per lavorare in settori specifici, ad esempio in campo medico, ma più difficile immaginare, sottolineano i ricercatori, possa essere introdotta da quelle aziende che sviluppano chatbot 'generalisti' che puntano proprio sulla capacità di risposta in settori molto ampi.

R.Kloeti--VB