-

Usa, via libera alla vendita di Patriot per 9 miliardi all'Arabia Saudita

Usa, via libera alla vendita di Patriot per 9 miliardi all'Arabia Saudita

-

Venezuela, El Helicoide sarà chiuso e trasformato in uno spazio sociale

-

Venezuela, restituito il passaporto al cardinale Porras

Venezuela, restituito il passaporto al cardinale Porras

-

ExxonMobil entra nel mercato carburanti in Ecuador

-

Il Nicaragua riorganizza la sua diplomazia, Moncada torna cancelliere

Il Nicaragua riorganizza la sua diplomazia, Moncada torna cancelliere

-

Maria Antonietta e Colombre, la felicità è democratica e noi la rapiniamo

-

'Dmitriev domani a Miami per incontrare membri amministrazione Trump'

'Dmitriev domani a Miami per incontrare membri amministrazione Trump'

-

Fonti Mimit, in arrivo 1,6 miliardi del Fondo automotive fino al 2030

-

C'è un interruttore che blocca la produzione di cellule adipose

C'è un interruttore che blocca la produzione di cellule adipose

-

De Zerbi non arretra, a Marsiglia "altri cinque o sei anni"

-

Addio a Catherine O'Hara, protagonista in Mamma ho perso l'aereo e Schitt's Screek

Addio a Catherine O'Hara, protagonista in Mamma ho perso l'aereo e Schitt's Screek

-

Fermin Lopez prolunga il contratto con il Barcellona

-

Sindacati, da Woolrich-Basicnet ritiro dei trasferimenti unilaterali

Sindacati, da Woolrich-Basicnet ritiro dei trasferimenti unilaterali

-

Milleproroghe, verso estensione dei bonus donne, giovani e Sud

-

Lepore, c'è la garanzia che il marchio Woolrich sopravviverà

Lepore, c'è la garanzia che il marchio Woolrich sopravviverà

-

Sanità, nel Lazio dal primo febbraio cambia la validità delle ricette

-

Jovanotti, "da oggi sono Commendatore della Repubblica, grande onore"

Jovanotti, "da oggi sono Commendatore della Repubblica, grande onore"

-

Trovato il freno del principale tumore cerebrale pediatrico

-

Borsa: Milano e l'Europa forti dopo l'indicazione di Warsh alla Fed

Borsa: Milano e l'Europa forti dopo l'indicazione di Warsh alla Fed

-

Putin riceve il capo del Consiglio di sicurezza iraniano Larijani

-

F1: le Ferrari brillano nell'ultimo giorno di test a Barcellona

F1: le Ferrari brillano nell'ultimo giorno di test a Barcellona

-

Hit parade, Geolier si conferma in vetta ad album e singoli

-

Spuntano a Liverpool le prime immagini dei 'Beatles' di Mendes

Spuntano a Liverpool le prime immagini dei 'Beatles' di Mendes

-

Il gas conclude in rialzo (+1,8%) a 39,2 euro al Megawattora

-

Vitagliano, 'le raccomandazioni sono ovunque, anche in tv'

Vitagliano, 'le raccomandazioni sono ovunque, anche in tv'

-

Ghost torna al cinema in versione restaurata 4K per San Valentino

-

Satelliti Ue rilevano i maggiori incendi in 20 anni in Patagonia

Satelliti Ue rilevano i maggiori incendi in 20 anni in Patagonia

-

ll Rof si esibisce a Pechino per il 55/o delle relazioni Italia-Cina

-

Il Dipartimento di Giustizia Usa pubblica nuove carte su Epstein

Il Dipartimento di Giustizia Usa pubblica nuove carte su Epstein

-

Le cellule tumorali diventano più aggressive se sono compresse

-

Voci di mercato, Mateta non convocato dal Crystal Palace

Voci di mercato, Mateta non convocato dal Crystal Palace

-

Verso Pordenone 2027, presentato il nuovo sito

-

Champions: playoff; si parte con Galatasaray-Juventus martedì 17 febbraio

Champions: playoff; si parte con Galatasaray-Juventus martedì 17 febbraio

-

I Trump bloccano la stampa alla prima di 'Melania'

-

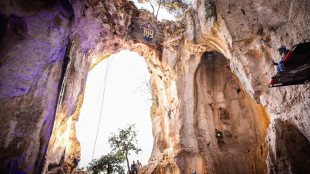

Red Bull Ivy 2026, lo spettacolo dell' arrampicata si accende

Red Bull Ivy 2026, lo spettacolo dell' arrampicata si accende

-

Sindacati, domani sciopero di 4 ore del personale navigante di EasyJet

-

Venezuela, le autorità elettorali sospendono l'iscrizione di nuovi partiti politici

Venezuela, le autorità elettorali sospendono l'iscrizione di nuovi partiti politici

-

Regina (Confindustria), 'Energia e bollette sono tema di sicurezza nazionale'

-

Ex Ilva: Mimit, mandato a negoziato in esclusiva con Flacks, possibili partner

Ex Ilva: Mimit, mandato a negoziato in esclusiva con Flacks, possibili partner

-

Djokovic 'Sinner e Alcaraz livello super, ma si possono battere'

-

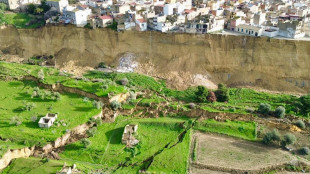

I satelliti italiani Cosmo-SlyMed puntati sulla frana di Niscemi

I satelliti italiani Cosmo-SlyMed puntati sulla frana di Niscemi

-

Il Chelsea apre alla partenza di Disasi

-

Borsa: Milano (+1%) solida con l'Europa dopo l'avvio di Wall street

Borsa: Milano (+1%) solida con l'Europa dopo l'avvio di Wall street

-

Wall Street apre in calo, Dj -0,32%, Nasdaq -0,33%

-

In Austria il cancelliere Stocker invoca riforme, anche del servizio militare

In Austria il cancelliere Stocker invoca riforme, anche del servizio militare

-

'Franco Battiato. Un'altra vita', al Maxxi la mostra-evento sul musicista

-

Il petrolio in calo a New York a 64,99 dollari

Il petrolio in calo a New York a 64,99 dollari

-

Delia, da X Factor al Sicilia Bedda Tour

-

Vigilia di Grammy con Lady Gaga e Bieber sul palco

Vigilia di Grammy con Lady Gaga e Bieber sul palco

-

Piovani dirige Piovani per il Teatro Comunale di Bologna

Le IA non sanno distinguere tra opinioni personali e i fatti

Studio, limitazione cruciale, rischio disinformazione

I grandi modelli linguistici di Intelligenza Artificiale come ChatGpt non sono affidabili quando si tratta di distinguere tra opinioni personali e fatti: una limitazione cruciale, vista la crescente diffusione di questi strumenti in ambiti chiave come la medicina, il diritto, il giornalismo e la scienza, nei quali è imperativa la capacità di distinguere la realtà dalla finzione. Lo afferma lo studio pubblicato sulla rivista Nature Machine Intelligence e guidato dall'Università americana di Stanford: evidenzia la necessità di essere cauti nell'affidarsi a questi programmi e il rischio che possano favorire la diffusione della disinformazione. I ricercatori coordinati da James Zou hanno messo alla prova 24 Large Language Model i cosiddetti Llm, tra cui ChatGpt della californiana OpenAI e il cinese DeepSeek, ponendo loro 13mila domande. Quando è stato chiesto di verificare dati fattuali veri o falsi, la precisione è risultata elevata pari a oltre il 91% per le versioni più nuove dei programmi. Passando alle credenze espresse in prima persona, invece, tutti i modelli testati hanno fallito: Gpt 4, la versione rilasciata a maggio 2024, ha visto scendere la sua affidabilità dal 98,2% al 64,4%, mentre la versione R1 di DeepSeek è precipitata addirittura da oltre il 90% al 14,4%. La riduzione dell'accuratezza è stata meno marcata per le opinioni espresse in terza persona e ciò, secondo gli autori dello studio, rivela un preoccupante bias di attribuzione, cioè una distorsione nel modo in cui vengono valutate le affermazioni fatte da altri. Inoltre, gli Llm risultano meno propensi a riconoscere una credenza falsa rispetto ad una vera: più precisamente, il 34,3% meno propensi per gli ultimi modelli. I ricercatori affermano, dunque, che miglioramenti in questo ambito sono urgentemente necessari se si vuole prevenire la diffusione di fake news.

L.Maurer--VB